Методика поверки «Стенды для испытаний двигателей внутреннего сгорания с системой автоматизации PUMA Open ENGINE TESTING» (МП 207-002-2020)

СОГЛАСОВАНО

директор

А.Ю. Грабовский

УТВЕРЖДАЮ

.В. Иванникова

«30» января 2020 г.

Заместитель директора НИИМС»

Стенды для испытаний двигателей внутреннего сгорания с системой автоматизации PUMA Open ENGINE TESTINGМЕТОДИКА ПОВЕРКИ

МП 207-002-2020

Москва

2020

Настоящая методика поверки распространяется на стенды для испытаний двигателей внутреннего сгорания с системой автоматизации PUMA Open ENGINE TESTING (далее -стенды), предназначенные для научно-исследовательских, доводочных и сертификационных испытаний вновь разрабатываемых и серийно выпускаемых двигателей на соответствие требованиям ГОСТ 14846-81 и международных экологических стандартов, на ПАО «Автодизель», г. Ярославль.

Интервал между поверками - 1 год.

Настоящая методика состоит из нескольких разделов.

Раздел 1 Поверка устройств для измерения крутящего момента и частоты вращения.

Раздел 2 Поверка измерителя расхода топлива AVL 735S.

Раздел 3 Поверка каналов измерений температуры.

Раздел 4 Поверка каналов измерений давления.

Раздел 5 Поверка измерительных каналов ОТ (отработанных газов).

Раздел 1

Поверка устройств для измерения крутящего момента и частоты вращения

-

1.1 Операции и средства поверки устройств для измерения крутящего момента и частоты вращения

1.1.1 Используемые средства поверки и их технические характеристики приведены в таблице 1.1.

Таблица 1.1

|

№ п/п |

Наименование оборудования |

Метрологические характеристики |

|

1 |

Гири |

КТ Ml, 20 кг, 10 шт |

|

2 |

Тахометр АТТ серии 6000 |

ПГ±(0,1%+1 е. м. р.) от 10 до 10? об/мин |

|

3 |

Поверочный рычаг |

Вспомогательное оборудование |

При поверке могут использоваться и другие аналогичные средства поверки, удовлетворяющие указанным выше требованиям и имеющие действующие свидетельства о поверки.

-

1.1.2 При проведении поверки должны выполняться операции, указанные в таблице

1.2.

Таблица 1.2

|

Наименование испытаний |

Номер пункта |

Обязательность проведения операций при: | |

|

первичной поверке |

периодической поверке | ||

|

1 Внешний осмотр |

1.3 |

+ |

+ |

|

2 Опробование и подтверждение соответствия программного обеспечения |

1.4 |

+ |

+ |

|

3 Определение погрешности канала измерения крутящего момента силы на валу двигателя |

1.5.1 |

+ |

4- |

|

4 Определение пределов допускаемой приведенной погрешности измерений частоты вращения к диапазону измерений |

1.5.2 |

+ |

4- |

-

1.2 Условия поверки

Операции по всем пунктам настоящей методики проводят при любом из сочетаний значений влияющих факторов, соответствующих рабочим условиям эксплуатации поверяемых устройств:

-

- температура окружающего воздуха, °C 20±10

-

- напряжение питания переменным током, В 22О.зз+22

-

- частота питания, Гц 50±1

При проведении поверки должны быть соблюдены требования безопасности, указанные в эксплуатационной документации на поверяемые устройства, а также на используемое поверочное и вспомогательное оборудование.

При проведении поверки устройства не должны подвергаться воздействию вибраций, сотрясений, сильных электрических и магнитных полей, которые могут повлиять на результаты измерений.

Вся контрольно-измерительная аппаратура, используемая для измерений, должна быть поверена и иметь свидетельства о поверке или отметку о регистрации поверки в технической документации с действующим сроком.

Подготовку к поверке проводят в объеме подготовки поверяемых устройств к работе методами, приведенными в эксплуатационной документации.

-

1.3 Внешний осмотр

При проведении внешнего осмотра должно быть проверено:

-

- отсутствие механических повреждений;

-

- надежность крепления всех элементов устройства;

-

- наличие и прочность крепления всех органов управления;

-

- наличие предохранителей;

-

- состояние лакокрасочных покрытий и четкость маркировок.

Изоляция электрической проводки установки не должна иметь повреждений. При наличии дефектов устройство подлежит ремонту.

-

1.4 Опробование и подтверждение соответствия программного обеспечения

-

1.4.1 При опробовании проверяют соответствие функционирования устройства требованиям эксплуатационной документации и наблюдают за работой устройства.

-

1.4.2 Подтверждение соответствия программного обеспечения осуществляется в следующей последовательности:

-

- подготовить и включить стенд в соответствии с эксплуатационной документацией;

-

- запустить на рабочем месте оператора программу AVL PUMA OPEN и проверить идентификационное наименование и номер версии (идентификационный номер) ПО.

Результаты поверки считать положительными, если идентификационные данные ПО соответствуют данным, приведенным в таблице 1.3.

Таблица 1.3

|

Идентификационные данные (признаки) |

Значение |

|

Идентификационное наименование ПО |

AVL PUMA OPEN |

|

Номер версии (идентификационный номер) ПО, не ниже |

1.3 |

|

Цифровой идентификатор программного обеспечения |

отсутствует |

-

1.5 Определение метрологических характеристик

-

1.5.1 Определение приведенной погрешности при измерении крутящего момента силы производится при помощи поверочного рычага из комплекта поставки (Приложение 1) и гирь класса точности Ml.

Определение погрешности канала измерений крутящего момента силы проводить на диапазоне от 200 до 2000 Н м.

-

1.5.1.1 Установить поверочный рычаг на вал стенда, закрепив его болтами в местах крепления. Застопорить вал фиксатором.

-

1.5.1.2 Для приложения крутящего момента силы по часовой стрелке, установить подвес на призму на правое плечо поверочного рычага. Обнулить показания на дисплее пульта управления стендом.

-

1.5.1.3 Рассчитать значения крутящего момента силы прикладываемого к валу для шести точек по формуле:

где:

Мп - расчётное значение крутящего момента силы прикладываемого к валу, Н м;

Lp - длина плеча, взятая из Приложения 1, м

g - ускорение свободного падения в месте установки стенда, м/с2 (g = 9,816956);

тп - суммарная масса гирь, установленных на подвес, кг.

Значение суммарной массы гирь в прикладываемых точках соответствует 20 кг, 40 кг, 80 кг, 120 кг, 160 кг, 200 кг.

-

1.5.1.4 Провести обжатие стенда. Для этого поместить на подвес массу равную 200 кг. Выдержать систему под нагрузкой в течение 5 минут. Разгрузить систему. Обнулить показания на дисплее пульта управления стендом.

-

1.5.1.5 Произвести нагружение стенда крутящим моментом силы (Мп) в шести точках, помещая на подвес суммарное значение масс гирь (/?/„), указанных в пункте 1.5.1.3. Записать значения, полученные на дисплее пульта управления стендом, в каждой точке. Разгрузить систему. Произвести три полных цикла нагружений (/=3).

-

1.5.1.6 Значение приведённой погрешности в каждой поверяемой точке рассчитать по формуле:

(2)

max

где

Уу - значение приведённой погрешности измерений крутящего момента силы на /-ой ступени j-ого цикла, %;

Му - значение крутящего момента отображаемое на дисплее пульта управления стендом на /-ой ступени j-ого цикла, Н м;

Мтах - максимальный диапазон измерений крутящего момента силы стендом, Н м.

-

1.5.1.7 Приведённую погрешность измерения крутящего момента силы рассчитать по формуле:

-

1.5.1.8 Повторить процедуру, описанную в пунктах с 1.5.1.3 по 1.5.1.7, для приложения крутящего момента силы против часовой стрелке.

-

1.5.1.9 Приведённая погрешность измерений крутящего момента силы по и против часовой стрелки не должна превышать ±0,25%.

-

1.5.2 Определение пределов допускаемой приведенной погрешности измерений частоты вращения к диапазону измерений.

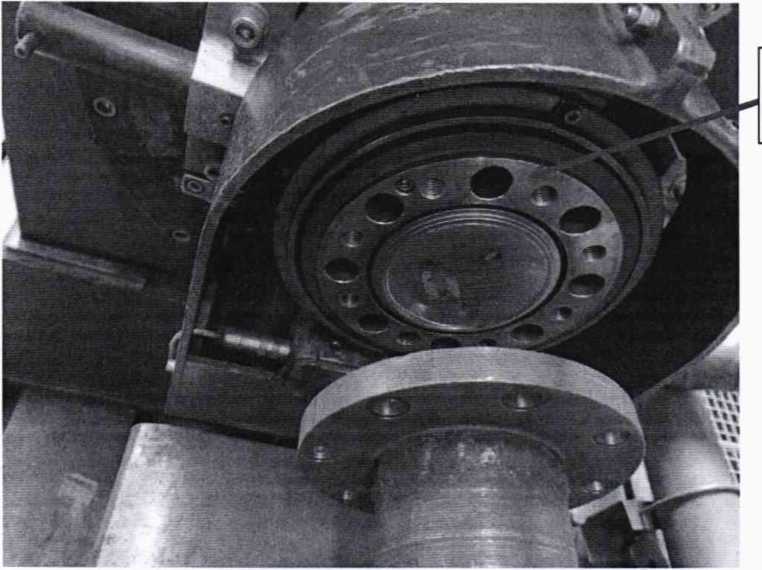

Наклеить на валу асинхронного электрического тормоза, светоотражающую полоску входящую в комплект тахометра АТТ серии 6000 в месте указанном на рисунке 1:

Место нанесения светоотражающей полоски

а) измерения частоты вращения проводить в соответствии с руководством по эксплуатации тахометра АТТ серии 6000 или аналогичного.

б) измерение частоты вращения проводить не менее чем в восьми числовых отметках, равномерно распределенных на всем диапазоне измерения.

в) записать соответствующие значения, отображаемые на мониторе системы автоматизации PUMA Open и ручном тахометре.

Значение приведенной погрешности у определяют по формуле:

/ = X100% (4)

( .макс ^.мии )

где:

пизм - измеренное значение частоты вращения;

пд- действительное значение частоты вращения;

Пмакс- максимальное значение частоты вращения по технической документации; пмин- минимальное значение частоты вращения по технической документации.

Стенд для испытаний двигателей внутреннего сгорания с системой автоматизации PUMA Open ENGINE TESTING считается прошедшим поверку по данному пункту, если допускаемая приведенная погрешность измерений частоты вращения к диапазону измерений не превышает: ±0,5 %.

Раздел 2 Поверка измерителя расхода топлива AVL 735S

-

2.1 Операции и средства поверки измерителя расхода топлива AVL 735S

При проведении поверки должны выполняться операции, указанные в таблице 2.1.

Таблица 2.1

|

Наименование операции |

Номер пункта |

Проведение операции при | |

|

первичной поверке |

периодической поверке | ||

|

1 Внешний осмотр |

2.4.1 |

+ |

+ |

|

2 Опробование и подготовка к поверке, подтверждение соответствия программного обеспечения |

2.4.2 |

+ | |

|

3 Определение метрологических характеристик |

2.4.3 |

+ |

+ |

|

3.1 Определение относительной погрешности измерения массы |

2.4.3.1 |

+ |

+ |

|

3.2 Определение относительной погрешности измерения интервалов времени |

2.4.3.2 |

+ |

+ |

|

3.3. Определение относительной погрешности измерения расхода |

2.4.3.3 |

+ |

+ |

Используемые средства поверки и их характеристики приведены в таблице 2.2.

Таблица 2.2

|

№ п/п |

Наименование оборудования |

Метрологические характеристики |

|

1 |

Весы лабораторные электронные LP3200D (Госреестр №22403-03) |

Пределы допускаемой погрешности в интервале взвешивания от 1000 г до 2000 г не более ±50 мг (в эксплуатации) |

|

2 |

Секундомер механический СДСпр-1 (ТУ 25-1819.0021-90), скачок секундной стрелки 0,1 с |

Максимальная относительная погрешность при нормальных условиях при измерении интервала времени 600 - не более ±0,35% |

При поверке могут использоваться и другие аналогичные средства поверки, удовлетворяющие указанным выше требованиям и имеющие действующие свидетельства о поверке.

Перечисленные средства поверки и вспомогательное оборудование должны работать в условиях, оговоренных в соответствующей нормативной документации.

-

2.2 Требования безопасности

При поверке измерителя необходимо ознакомиться с эксплуатационной документацией и с настоящей методикой поверки.

При проведении поверки должны соблюдаться требования безопасности согласно эксплуатационной документации на измеритель, а также на используемые при поверке средства поверки и испытательного оборудования.

-

2.3 Условия поверки

Операции по всем пунктам настоящего раздела проводят при любом из сочетаний значений следующих влияющих факторов:

-

- температура окружающего воздуха, С 20±10

-

- относительная влажность воздуха, % 60±20

-

2.4 Проведение поверки

-

2.4.1 Внешний осмотр

-

Внешний осмотр производится путем визуальной проверки внешнего вида измерителя.

При внешнем осмотре проверяются соответствие внешнего вида устройства эксплуатационной документации и комплектность. На маркировочной табличке устройства, расположенной на их корпусе, должны быть указаны наименование или товарный знак предприятия-изготовителя, обозначение устройства, заводской номер, год выпуска.

Проверяется отсутствие видимых повреждений устройства, целостность сетевых кабелей, соединительных коммуникаций.

-

2.4.2 Опробование и подготовка к поверке, подтверждение соответствия программного обеспечения

-

2.4.2.1 При опробовании устройство подключается к источнику сетевого питания в соответствии с эксплуатационной документацией. Производят включение устройства и наблюдают за его работой в течение 15 мин. Система автоматизации PUMA Open должна находиться в режиме «Monitor». Производится присоединение расходомера топлива AVL735S и кондиционера топлива AVL753S к измерительной системе стенда. К расходомеру топлива AVL735S и кондиционеру топлива AVL753S подключена линия сжатого воздуха, электропитание включено. Прямая и обратная топливные трубки подачи топлива на двигатель должны быть перекрыты, обеспечена герметичность топливопроводов. Функционирование узлов устройства должно соответствовать требованиям эксплуатационной документации.

-

2.4.2.2 Подтверждение соответствия программного обеспечения осуществляется в соответствии с п. 1.4.2 настоящей методики.

-

-

2.4.3 Определение метрологических характеристик

Все операции по поверке проводятся после прогрева системы в установившемся режиме. Перед проведением поверки допускается проведение калибровки устройства.

-

2.4.3.1. Определение относительной погрешности измерений массы

Определение относительной погрешности измерений массы топлива:

-

1) включить интегральный замер массы топлива в окне оператора системы управления стендом ПУМА,

-

2) заполнить технологический резервуар, сливая топливо из топливного фильтра поверяемого массового расходомера AVL 735,

-

3) записать показания массы топлива в окне оператора системы управления стендом ПУМА,

-

4) провести измерение массы заполненного технологического резервуара на весах.

Провести данную процедуру три раза для каждого из следующих трех поддиапазонов величины расхода топлива, устанавливая расход сливаемого топлива по показаниям системы управления стендом ПУМА в соответствующем поддиапазоне:

-

- 1: от 0,2 до 30 кг/час,

-

- 2: от 30 до 70 кг/час,

-

- 3: от 70 до 125 кг/час,

и определить для каждого поддиапазона среднее значение измеренной массы по формуле:

— (М„ + М12 +М,3)

М, = -—(5) 'в 3

где:

i - номер поддиапазона, i = 1, 2, 3

j - номер замера на каждом поддиапазоне, j = 1, 2, 3

у - абсолютная погрешность j-го измерения на i-м поддиапазоне,

-

5) определить относительную погрешность в каждом поддиапазоне:

6Му = I Му, юм. - Му, в| / MiJt в * 100% (6)

где:

Му, юм - измеренное на j-м измерении на i-м поддиапазоне в окне оператора системы управления стендом ПУМА значение массы топлива, г;

Му, в - значение массы топлива, полученное при измерении слитого топлива на весах на j-м измерении на i-м поддиапазоне, г,

Относительной погрешностью измерений массы принимаем равной наибольшему из рассчитанных значений относительных погрешностей измерений массы на диапазонах 1, 2 и 3:

ЗМ = max(3Mi; ЗМ2; ЗМ3) (7)

-

2.4.3.2. Определение относительной погрешности измерений интервалов времени Процедура замера величины интервала времени.

-

- В окне оператора системы управления стендом запустить процедуру определения интегрального значения массы топлива, при этом топливо не сливать.

-

- одновременно с этим запустить замер времени секундомером,

-

- остановить оба замера через 600 - 700 с.

Повторить данную процедуру три раза определить относительную погрешность измерения величины интервала времени по формуле:

3Ti = |T,i„3M.-Ti,B|/Ti,B* 100% (8)

где:

i - номер замера, i = 1, 2, 3

T.i изм - длительность промежутка времени, измеренная в окне оператора системы управления стендом ПУМА, с,

Tj, в - длительность промежутка времени, измеренная секундомером, с.

Относительная погрешность измерения интервала времени принимается равной:

— (оГ, + <УГг + <УГ})

3 (9)

-

2.4.3.3 Определение относительной погрешности измерения массового расхода топлива

Относительная погрешность измерения массового расхода топлива 5Q принимается равной: ____________

8Q = + 8Т1 (10)

Стенды для испытаний двигателей внутреннего сгорания с системой автоматизации PUMA Open ENGINE TESTING считаются прошедшими поверку по данному пункту, если допускаемая относительная погрешность измерений массового расхода топлива не превышает: ±1 %.

Раздел 3

Поверка каналов измерений температуры

-

3.1 Операции и средства поверки каналов измерений температуры

-

3.1.1 При проведении поверки должны проводиться операции, указанные в таблице

-

3.1.

Таблица 3.1

|

Наименование операции |

Номер пункта по поверке |

Проведение операции при | |

|

Первичной поверке |

Периодической поверке | ||

|

1. Внешний осмотр |

3.4.1 |

+ |

+ |

|

2. Опробование и подтверждение соответствия программного обеспечения |

3.4.2 |

+ |

+ |

|

3. Определение абсолютной погрешности каналов измерений температуры |

3.4.3 |

+ |

+ |

3.1.2 Используемые средства поверки и их характеристики приведены в таблице 3.2. Таблица 3.2

|

№ п/п |

Наименование и тип средств измерений и оборудования |

Метрологические характеристики или регистрационный номер в Федеральном информационном фонде по обеспечению единства измерений |

|

1 |

Термометр лабораторный ЛТ-300 |

Регистрационный № 61806-15 |

|

2 |

Термометр лабораторный электронный LTA |

Регистрационный № 69551 -17 |

|

3 |

Калибратор-измеритель унифицированных сигналов эталонный ИКСУ-2000 |

Регистрационный № 20580-06 |

|

4 |

Калибратор многофункциональный и коммуникатор BEAMEX МС6 (-R) |

Регистрационный № 52489-13 |

|

5 |

Термостат жидкостный низкотемпературный КРИО-ВТ-2 |

Диапазон воспроизводимых температур: от -20 до +200 °C; нестабильность поддержания установленной температуры: ±0,1 °C |

Примечания:

1 Все средства измерений, применяемые при поверке, должны иметь действующие

свидетельства о поверке.

2 Допускается применение аналогичных средств поверки, обеспечивающих определение метрологических характеристик поверяемых СИ с требуемой точностью.

-

3.2 Требования безопасности

При проведении поверки должны соблюдаться требования безопасности согласно эксплуатационной документации на стенд для испытания двигателей внутреннего сгорания фирмы «AVL LIST GmbH» (далее - стенд), а также на используемые при поверке средства поверки и испытательное оборудование.

3.3 Условия поверки:

-

- температура окружающего воздуха, °C

-

- напряжение питания переменным током, В

-

- частота питания, Гц

-

- относительная влажность воздуха, %

20±10

220.33

50±1

65±15

-

3.4. Проведение поверки

-

3.4.1 Внешний осмотр

Внешний осмотр производится путем визуальной проверки внешнего вида стенда.

При внешнем осмотре проверяют соответствие внешнего вида стенда эксплуатационной документации и комплектность. На маркировочной табличке стенда, расположенной на корпусе, должны быть указаны наименование или товарный знак предприятия-изготовителя, обозначение стенда, заводской номер, год выпуска.

Проверяется отсутствие видимых повреждений, целостность сетевых кабелей, соединительных коммуникаций.

При внешнем осмотре датчиков температуры устанавливают соответствие серийных номеров датчиков температуры, указанных в формуляре на стенд и отображение всех каналов модулей с АРМ оператора.

-

3.4.2 Опробование и подтверждение соответствия программного обеспечения

-

3.4.2.1 Контроль работоспособности датчиков температуры производят путем считывания измеренных значений с дисплея компьютера системы автоматизации PUMA Open.

Согласно эксплуатационной документацией на стенд и руководства пользователя на программное обеспечение PUMA Open проверяют возможность сбора и хранения результатов измерений, формирование баз данных в соответствии с заданными параметрами, формирование на основе полученной информации и представлении на дисплее различных графиков.

Проверяют значения установленных границ диапазонов измерений.

-

3.4.2.2 Подтверждение соответствия программного обеспечения осуществляется в соответствии с п. 1.4.2 настоящей методики.

-

3.4.3 Определение абсолютной погрешности каналов измерения температуры

-

3.4.3.1 Определение погрешности каналов измерений температуры всасываемого воздуха, охлаждаемой жидкости, масла и топлива определяют в нескольких равномерно расположенных температурных точках рабочего диапазона измерений, включая начальное и конечное значения, но не менее чем в пяти температурных точках. Рабочие диапазоны каналов измерений температуры приведены в таблице 3.3.

Таблица 3.3

|

Канал измерений |

Диапазон измерений, °C |

|

Температура всасываемого воздуха |

от 0 до +60 |

|

Температура охлаждающей жидкости |

от 0 до +150 |

|

Температура масла |

от 0 до +150 |

|

Температура топлива |

от 0 до +60 |

-

3.4.3.2 Определение погрешности каналов измерений температуры проводят следующим образом:

-

- датчик температуры Pt 100 извлечь из трубопровода;

-

- подготовить и установить в жидкостном термостате первую контрольную точку в соответствии с эксплуатационной документацией;

-

- поместить датчик Pt 100 и погружаемую часть эталонного термометра в термостат и выдержать до установления теплового равновесия между эталонным термометром, поверяемым датчиком и термостатирующей средой, но не менее 10 минут;

-

- считать с АРМ оператора значения температуры датчика в каждой контрольной точке.

-

- рассчитать абсолютную погрешность каналов измерений температуры по формуле:

Аик=Тизм_Тэт (11)

где:

Тизм - значение температуры, считанное с АРМ оператора, °C;

Тэт- значение температуры, измеренное эталонным термометром, °C.

-

3.4.3.2 При определении погрешности канала измерений температуры отработанных газов используют калибратор ВЕАМЕХ для генерации напряжения на электрической части измерительного канала. (Под электрической частью измерительного канала понимается часть канала, начиная с выходных клемм датчика и заканчивая дисплеем системы автоматизации PUMA Open).

Датчик температуры для измерения отработанных газов должен иметь действующее свидетельство о поверке. Поверка датчиков температуры (преобразователей термоэлектрических) осуществляется по ГОСТ 8.338-2002 «ГСП. Преобразователи термоэлектрические. Методика поверки» и по МИ 3090-2007 «ГСИ. Преобразователи термоэлектрические с длиной погружаемой части менее 250 мм. Методика поверки» (для ТП с длиной погружаемой части менее 250 мм).

Определение абсолютной погрешности измерения температуры Дт^ электрической частью измерительного канала проводят в указанной ниже последовательности.

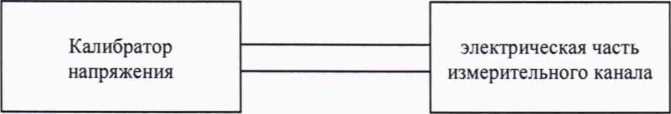

- собирают схему измерений согласно рис. 3.1, присоединяя выходные зажимы калибратора напряжения к выходным клеммам сигнальной цепи датчика температуры: 0-42 мВ.

Рис. 3.1

- определяют и записывают в таблицу 3.4 пять значений напряжения, равномерно расположенных по диапазону измерений проверяемого канала. Для электрической части канала измерений температуры отработанных газов заданного значения напряжения в диапазоне от 2,023 до 41,276 мВ: 2,023 мВ; 10,153 мВ; 20,644 мВ; 31,213 мВ: 41,276 мВ.

Таблица 3.4

|

Заданное значение постоянного напряжения, мВ |

Заданное значение, °C Тзад |

Измеренное значение на дисплее, °C Тизм |

Полученное значение абсолютной погрешности измерения температуры, °C ^Тог изм. |

Нижний предел допускаемых значений °C, Пн |

Верхний предел допускаемых значений °C, пв |

|

2,023 |

50 |

48 |

52 | ||

|

10,153 |

250 |

248 |

252 | ||

|

20,644 |

500 |

498 |

502 | ||

|

31,213 |

750 |

748 |

752 | ||

|

41,276 |

1000 |

998 |

1002 |

-

- последовательно устанавливают на калибраторе значения напряжения по таблице 3.4;

-

- на дисплее компьютера фиксируют измеренное значение Тизм в единицах физической величины и записывают их в таблицу 3.4;

-

- рассчитывают абсолютную погрешность измерения температуры по формуле:

&Тог мхи. = Тизм - Тзад (12)

-

- определение абсолютной погрешности измерений температуры измерительным каналом системы производится по формуле:

Д И К = Ы д/д Тог изм + Д ДС ()

где:

&ик - абсолютная погрешность измерения температуры измерительным каналом стенда, °C;

Дгог U3M- абсолютную погрешность измерения температуры электрической частью измерительного канала системы, полученная экспериментально в реальных условиях эксплуатации системы (Таблица 3.4), °C;

Ддс - пределы допускаемого отклонения ТЭДС от НСХ (в температурном эквиваленте) датчика (термоэлектрического преобразователя) для измерения температуры отработанных газов (в соответствии с Описанием типа), °C.

Результаты проверки считать положительными, если при каждом заданном значении физической величины абсолютная погрешность измерительного канала системы при измерении:

-

- температуры всасываемого воздуха не выходит за пределы ±1 °C;

-

- температуры охлаждающей жидкости не выходит за пределы ±2 °C;

-

- температуры масла не выходит за пределы ±2 °C;

-

- температуры топлива не выходит за пределы ±2 °C;

-

- температуры отработанных газов не выходит за пределы ±20 °C.

Раздел 4

Поверка каналов измерений давления

Стенд включает в себя два вспомогательных модуля C-FEM-P и F-FEM-AIN, которые предназначены для поканальных измерений избыточного и абсолютного давления. Каждый из вспомогательных модулей (C-FEM-P и F-FEM-AIN) может включать до 8 датчиков давления.

Перечень каналов модулей измерений давления в составе стенда приведен в таблице

4.1.

Таблица 4.1 - перечень каналов модулей измерений давления

|

Наименование канала |

Номер канала п/п на АРМ |

Наименование характеристики |

Значение |

|

Барометрического давления |

Р14 |

Диапазон измерений, кПа абс. |

от 80 до 120 |

|

Пределы допускаемой абсолютной погрешности измерений давления. кПа |

±0,2 | ||

|

Давления масла |

Р1;Р2; РЗ |

Диапазон измерений, кПа |

от 300 до 1000 |

|

Пределы допускаемой абсолютной погрешности измерений давления, кПа |

±20 | ||

|

Давления-разрежения воздуха на впуске |

Р7; Р9; |

Диапазон измерений, кПа |

от -15 до +5 |

|

Пределы основной приведенной погрешности измерений давления, % от диапазона измерений (ДИ) |

±3 | ||

|

Давления отработавших газов |

Р8;Р10 |

Диапазон измерений, кПа |

от -30 до +30 |

|

Пределы основной приведенной погрешности измерений давления, % от ДИ |

±3 | ||

|

Давления воздуха после компрессора |

Р4; Р5; Р6 |

Диапазон измерений, кПа |

от 0 до 250 |

|

Пределы основной приведенной погрешности измерений давления, % от ДИ |

±5 |

4.1 Операции поверки

При проведении поверки выполняют операции, указанные в таблице 4.2. Таблица 4.2 - Операции поверки

|

Наименование операции |

Номер пункта по поверке |

Проведение операции при | |

|

Первичной поверке |

Периодической поверке | ||

|

1. Внешний осмотр |

4.4 |

+ |

+ |

|

2. Опробование и подтверждение соответствия программного обеспечения |

4.5 |

+ |

+ |

|

3. Определение метрологических характеристик |

4.6 |

+ |

+ |

-

4.2. Средства поверки

-

4.2.1 При проведении поверки применяют средства поверки, указанные в таблице 4.3.

Таблица 4.3 - Средства поверки

|

Наименование средства поверки |

Регистрационный № |

|

Манометр избыточного давления грузопоршневой МП-2,5; МП-60 |

58794-14 |

|

Манометр абсолютного давления МПАК-15 |

24971-03 |

|

Задатчик давления Воздух-1600 |

12143-04 |

|

Калибратор давления Crystal с встроенным барометрическим модулем |

64480-16 |

|

Барометр рабочий сетевой БРС-1М-3 |

16006-97 |

-

4.2.2 Допускается применение аналогичных средств поверки, обеспечивающих определение метрологических характеристик поверяемых СИ с требуемой точностью в соответствии с приказом Федерального агентства по техническому регулированию и метрологии № 1339 «Об утверждении государственной поверочной схемы для средств измерений избыточного давления до 4000 МПа» при поверке каналов измерений избыточного давления и ГОСТ Р 8.840-2013 «ГСИ. Государственная поверочная схема для средств измерений абсолютного давления в диапазоне 1 - 1 • 106 Па» при поверке каналов измерений абсолютного давления.

-

4.3. Условия поверки и подготовка к ней

-

4.3.1 При поверке каналов модулей давления необходимо ознакомиться с эксплуатационной документацией на стенд и с настоящей методикой поверки.

При проведении поверки должны соблюдаться требования безопасности согласно эксплуатационной документации на стенд для испытания двигателей внутреннего сгорания фирмы «AVL LIST GmbH», а также на используемые при поверке средства поверки и испытательное оборудование.

4.3.2 Условия поверки:

-

- температура окружающего воздуха, °C

-

- напряжение питания переменным током. В

-

- частота питания, Гц

20±10

220-зз+22

50±1

-

- относительная влажность воздуха, % 65±15

-

- колебания давления окружающего воздуха, вибрация, тряска, удары, наклоны, магнитные поля и другие возможные воздействия на датчик давления при его поверке не должны приводить к выходу за допускаемые значения метрологических характеристик.

-

4.3.3 Перед проведением поверки выполнить следующие подготовительные работы:

-

- датчик давления выдерживают не менее 0,5 ч при включённом питании;

-

- проверяют на герметичность систему, состоящую из соединительных линий для передачи давления, эталонов и задатчиков давления.

-

4.3.4 Поверку датчиков давления допускается проводить без демонтажа, подключая эталонные средства измерений непосредственно к датчику давления, установленному в канал модуля измерений давления.

-

4.4. Внешний осмотр

-

4.4.1 При внешнем осмотре датчиков давления устанавливают:

-

-

- отсутствие дефектов;

-

— соответствие серийных номеров датчиков давления, указанных в формуляре стенда;

-

- отображение всех каналов модулей с АРМ оператора.

-

4.5 Опробование и подтверждение соответствия программного обеспечения

-

4.5.1 При опробовании проверяют герметичность и работоспособность датчиков давления.

-

4.5.2 Работоспособность датчиков давления проверяют, изменяя задаваемое давление от нижнего до верхнего предельных значений. При этом должно наблюдаться изменение значений давления на АРМ операторе.

-

4.5.3 Проверку герметичности датчиков давления рекомендуется совмещать с операцией определения его основной погрешности. При достижении ВПИ выдержать датчик давления 3 минуты.

-

4.5.4 Подтверждение соответствия программного обеспечения осуществляется в соответствии с п. 1.4.2 настоящей методики.

-

4.6 Определение метрологических характеристик

-

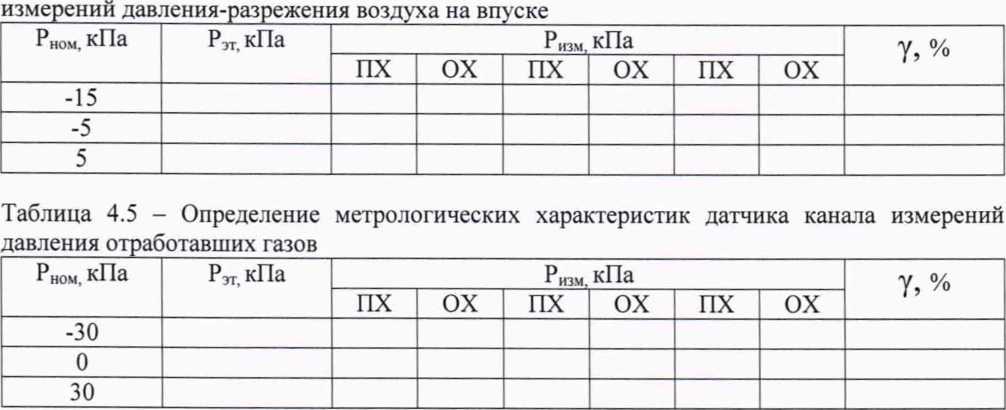

4.6.1 Определение основной приведенной к ДИ погрешности датчиков давления избыточного давления (каналы давления-разрежения воздуха на впуске, давления отработавших газов, давления воздуха после компрессора).

-

4.6.1.1 К датчику канала модуля измерений давления в зависимости от диапазона измерений подключить средство поверки в соответствии с его технической документацией.

-

4.6.1.2 Основную приведенную к диапазону измерений погрешность определить на 3 поверяемых точках и 3 циклах в каждой из поверяемых точек при изменении задаваемого давления от меньших значений к большим (прямой ход) и от больших значений к меньшим (обратный ход);

-

-

-

Значения результатов измерений датчиков давления считать с АРМ оператора.

-

4.6.1.3 Интервал между значениями измеряемой величины не должен превышать 60%. Рекомендуемые значения давления на поверяемых точках для датчиков избыточного давления приведены в таблицах 4.4 - 4.7.

Таблица 4.4 - Определение метрологических характеристик датчика давления канала

Таблица 4.6 - Определение метрологических характеристик датчика канала измерений давления воздуха после компрессора

|

Р ном, кПа |

Р)Т кПа |

Р изм. кПа |

у, % | |||||

|

ПХ |

ОХ |

ПХ |

ох |

ПХ |

ох | |||

|

0 | ||||||||

|

125 | ||||||||

|

250 | ||||||||

-

4.6.1.4 Определение основной приведенной к диапазону измерений погрешности датчиков избыточного давления рассчитать по формуле:

Л... х100о/о (14)

р - р

гвпи гнпи

Где:

у - основная приведенная к верхнему пределу измерений погрешность, %; Ризм - значение давления, измеренное первичным преобразователем, кПа; Рэт - значение давления, измеренное эталонным средством измерений, кПа; Рвпи - верхний предел измерений, кПа;

Рнпи - нижний предел измерений. кПа.

Таблица 4.7 - Определение метрологических характеристик датчика канала измерений давления масла

|

Р ном, кПа |

Рзт. кПа |

Р изм. кПа |

ДР, кПа | |||||

|

ПХ |

ОХ |

ПХ |

ох |

ПХ |

ох | |||

|

300 | ||||||||

|

650 | ||||||||

|

1000 | ||||||||

-

4.6.1.5 Определение абсолютной погрешности измерений датчика измерений давления масла выполнить по формуле:

ДР = |РНЗМ-РЭТ| (15)

где:

Ризм - значение давления, измеренное датчиком, кПа;

Рэт - значение давления, заданное калибратором, кПа.

-

4.6.2 Определение абсолютной погрешности датчика давления барометрического канала измерений.

-

4.6.2.1 В случае использования калибратора избыточного давления выполнить расчет поверяемых точек по формуле:

-

Ризб Рабе — Ратм (16)

где:

Рабе - абсолютное давление, кПа;

Ра™ - атмосферное давление, кПа;

Ризб - избыточное давление, кПа.

-

4.6.2.2 Абсолютную погрешность измерений определить на 3 поверяемых точках и 3 циклах в каждой из поверяемых точек при изменениях задаваемых значениях давления от меньших значений к большим (прямой ход) и от больших значений к меньшим (обратный ход).

Значения давлений датчика считать с АРМ оператора.

-

4.6.2.3 Интервал между значениями задаваемого давления не должен превышать 60%. Рекомендуемые значения абсолютного давления для датчика барометрического давления приведены в таблице 4.8.

Таблица 4.8 - Определение метрологических характеристик датчика канала измерений барометрического давления

|

Р ном, кПа |

Рэт, кПа |

Р изм. кПа |

ДР, кПа | |||||

|

ПХ |

ОХ |

ПХ |

ох |

ПХ |

ох | |||

|

80 | ||||||||

|

100 | ||||||||

|

120 | ||||||||

-

4.6.2.4 Определить абсолютную погрешность датчика барометрического давления по формуле:

Др = |РиЗМ. — ?эт| (17)

где:

РИзм - значение давления, измеренное датчиком, кПа;

Ртт - значение давления, заданное эталоном, кПа.

4.6.3 Каналы модулей измерений давления считаются прошедшим поверку, если основная допускаемая погрешность измерений не превышает значений, указанных в таблице

-

4.1.

Раздел 5

Поверка каналов измерений ОГ (отработанных газов)

-

5.1 Операции и средства поверки каналов измерений содержания отработанных газов (далее - ОГ)

5.1.1 При проведении поверки каналов измерений ОГ (система измерений ОГ АМА 1800) должны проводиться операции, указанные в таблице 5.1

Таблица 5.1

|

Наименование операции |

Номер пункта по поверке |

Проведение операции при | |

|

Первичной поверке |

Периодической поверке | ||

|

1. Внешний осмотр |

5.5.1 |

+ |

+ |

|

2. Опробование и подтверждение соответствия программного обеспечения |

5.5.2 |

+ |

+ |

|

3. Определение метрологических характеристик каналов измерений ОГ |

5.5.3 |

+ |

4- |

Примечание - при периодической поверке допускается выполнение частичной поверки (неполного перечня каналов измерений отдельных компонентов - в соответствии с потребностями организации, эксплуатирующей СИ).

-

5.1.2 Используемые для поверки государственные стандартные образцы - поверочные газовые смеси (далее ГСО-ПГС) и их характеристики приведены в таблице 5.2. Действительные значения объемной доли определяемых компонентов в поверочных газовых смесей (далее - ПГС) указаны в их паспортах.

Таблица 5.2

|

Измеряемый компонент |

Регистрационный номер, НД на газы и ГСО |

Диапазон измерений объемной доли компонента, млн' 1 |

ПГС | |||

|

№ |

Поверочный компонент |

Объемная доля компонента, млн'1 |

Пределы относительной погрешности действительного значения объемной доли компонента в ПГС, % | |||

|

Сумма углеводород ов ТНС в пересчете на метан СНд |

ТУ 6-21-5- 82 (с изм. 1 -6) |

от 0 до 1000 |

1 |

СНд |

ПНГ воздух0 | |

|

ГСО 10530-2014(СГЦв воздухе) |

2 |

СНд |

500 ±50 |

±2,5 | ||

|

3 |

СНд |

950 ±50 |

±2,5 | |||

|

Оксиды азота NOx в пересчете на NO |

ГОСТ 9293-74 |

от Одо 1000 |

1 |

NO |

- |

ПНГ азот2) |

|

ГСО 10545-2014- (NO в азоте) |

2 |

NO |

500 ±50 |

±2,5 | ||

|

3 |

NO |

950 ±50 |

±2,5 | |||

|

Оксид углерода COl (низкие) |

ГОСТ 9293-74 |

от 0 до 3000 |

1 |

СО |

- |

ПНГ азот2) |

|

ГСО 10531-2014-(СО в азоте) |

2 |

СО |

1500 ±150 |

±1,5 | ||

|

3 |

СО |

2850 ±150 |

±1,5 | |||

11 - Поверочный нулевой газ воздух марки «А» по ТУ 6-21-5-82 (с изм. 1 - 6),

2) — Азот газообразный особой чистоты по ГОСТ 9293-74, содержание основного вещества не менее 99,999 %.

Примечание - допускается применение государственных стандартных образцов состава газовых смесей (ГСО) с другими регистрационными номерами аналогичного состава и с метрологическими характеристиками, соответствующими (не хуже) указанным в таблице, а также аналогичных чистых и нулевых газов, выпускаемых по другим НД.

-

5.1.3 Если при проведении той или иной операции поверки получают отрицательный результат, дальнейшую поверку прекращают.

-

5.2. Требования безопасности

При проведении поверки выполняют:

-

- правила устройства и безопасной эксплуатации сосудов, работающих под давлением;

-

- правила техники безопасности при эксплуатации электроустановок;

-

- правила техники безопасности, в соответствии с инструкцией по эксплуатации системы измерения ОГ.

Вывод газовых трактов системы измерения отработанных газов должен быть соединён с общим трактом, отводящим отработанный газ за пределы рабочего помещения.

При продувке газовых трактов должна быть исключена возможность попадания токсичных газов в рабочее помещение.

|

5.3 Условия поверки

|

20±5 220+|5 от 30 до 90 |

Механические воздействия, наличие пыли, должны быть исключены.

-

5.4 Подготовка к поверке

Перед проведением поверки выполняют следующие подготовительные работы:

-

1) систему измерений подготавливают к работе в соответствии с технической документацией фирмы-изготовителя;

-

2) ПГС в баллонах выдерживают в помещении, в котором проводят поверку, в течение 24 часов;

-

3) пригодность ПГС должна быть подтверждена паспортами на них;

-

4) включают приточно-вытяжную вентиляцию.

-

5.5 Проведение поверки

-

5.5.1 Внешний осмотр

При внешнем осмотре устанавливают соответствие поверяемой системы измерений ОГ АМА 1800 следующим требованиям:

-

1) соответствие комплектности требованиям технической документации фирмы-изготовителя;

-

2) отсутствие повреждений, влияющих на работоспособность.

-

5.5.2 Опробование и подтверждение соответствия программного обеспечения

-

5.5.2.1 Опробование и работоспособность системы измерений ОГ, проверяют в соответствии с эксплуатационной документацией.

-

5.5.2.2 Подтверждение соответствия программного обеспечения осуществляется в соответствии с п. 1.4.2 настоящей методики.

-

5.5.3 Определение метрологических характеристик

-

5.5.3.1 При определении основной погрешности на вход соответствующих каналов измерений подают ПГС (таблица 5.2) в следующем порядке № 1 - № 2 - № 3. Результаты измерений фиксируют по показаниям, отображаемым на мониторе ПК стенда для соответствующих каналов измерений.

-

5.5.3.2 Значение погрешности, приведенной к диапазону измерений, 8 определяют по формуле:

д=А,~А° хЮ0% (18)

Л

где:

А, - показания объемной доли компонента ни мониторе ПК стенда, млн"1;

Ао - действительное значение объемной доли измеряемого компонента в поверочной газовой смеси, млн"1.

Ап - верхний предел измеряемого диапазона, млн"1.

-

5.5.3.3 Полученные значения погрешности, приведенной к диапазону измерений, не должны превышать ± 5 %.

Оформление результатов поверки

При положительных результатах поверки оформляется свидетельство о поверке в соответствии с Приказом № 1815 Минпромторга России от 02 июля 2015 г. Знак поверки наносится на свидетельство о поверке.

При отрицательных результатах поверки средство измерения изымают из обращения, и выдают извещение о непригодности с указанием причин в соответствии с Приказом № 1815 Минпромторга России от 02 июля 2015 г.

Допускается возможность проведения поверки от льных измерительных каналов с  обязательным занесением данной информации в свидетеЛыугво о поверке.

обязательным занесением данной информации в свидетеЛыугво о поверке.

Начальник отдела 202 ФГУП «ВНИИМС»

Начальник лаборатории 204 ФГУП «ВНИИМС»

Начальник отдела 205 ФГУП «ВНИИМС»

Е.А. Ненашева

А.Г. Волченко

С.В. Вихрова

Начальник отдела 207 ФГУП «ВНИИМС»

А.А. Игнатов

Зам. начальника отдела 208 ФГУП «ВНИИМС»

А.М. Шаронов

Заместитель генерального директора -

Руководитель группы механических измерений

ООО «ТестИнТех»

А.Ю. Зенин

Приложение 1

Поверочный рычаг из комплекта поставки.

1.0197210.0001 м

1.01972x0,0001 м

20